近年、携帯電話の世界は大きな変化を遂げています。サイズ、デザイン、パフォーマンス、その他のスマートな機能に焦点を当てるかどうかに関係なく、実質的にすべての側面で根本的な違いが見られます。現在、カメラの品質は比較的重要な役割を果たしています。現時点では、これはフラッグシップが常に競争しているスマートフォンの最も重要な側面の1つであると言えます。さらに、たとえば Android スマートフォンと Apple の iPhone を比較すると、多くの興味深い違いが見つかります。

かもしれない 興味がありますか

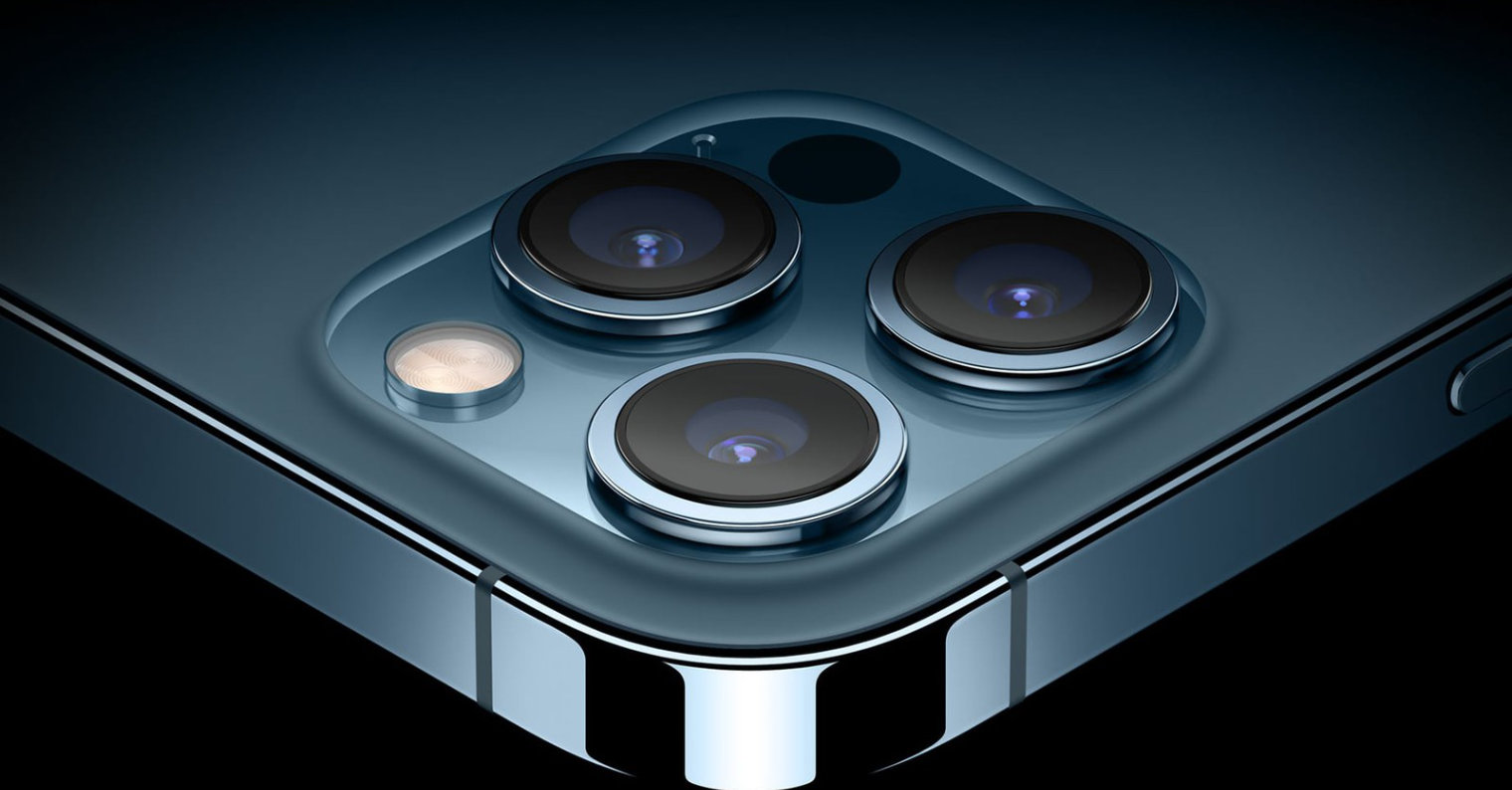

モバイル テクノロジの世界に興味がある場合は、最大の違いの 50 つがセンサーの解像度にあることをご存知でしょう。 Android では 12 万ピクセルを超えるレンズが提供されることがよくありますが、iPhone は何年も XNUMX 万ピクセルのみに賭けてきましたが、それでもより高品質の写真を提供できます。しかし、画像焦点合わせシステムにはあまり注目されていませんが、そこでかなり興味深い違いに遭遇します。 Android オペレーティング システムを搭載した競合携帯電話は、いわゆるレーザー オート フォーカスに(部分的に)依存していることが多いのですが、かじられたリンゴのロゴがついたスマートフォンにはこの技術がありません。それは実際にどのように機能するのか、なぜ使用されるのか、そして Apple はどのテクノロジーに依存しているのでしょうか?

レーザーフォーカス vs iPhone

前述のレーザー集束技術は非常に簡単に機能し、その使用は非常に理にかなっています。この場合、写真モジュールにはダイオードが隠されており、トリガーが押されると放射線が放射されます。この場合、ビームが送信され、撮影された被写体/物体で反射して戻ってきます。その時間を使用して、ソフトウェア アルゴリズムを通じて距離を迅速に計算できます。残念ながら、暗い側面もあります。遠距離で写真を撮影する場合、またはビームを確実に反射できない透明な物体や不利な障害物の写真を撮影する場合、レーザーの焦点はそれほど正確ではなくなります。このため、ほとんどの携帯電話は、シーンのコントラストを検出するために、長年にわたって実績のあるアルゴリズムに依然として依存しています。このようなセンサーを使用すると、完璧な画像を見つけることができます。この組み合わせは非常にうまく機能し、高速かつ正確な画像の焦点合わせを保証します。たとえば、人気の Google Pixel 6 にはこのシステム (LDAF) が搭載されています。

一方、iPhone は少し動作が異なります。しかし、本質的には非常に似ています。トリガーを押すと、近年大幅に改良された ISP または Image Signal Processor コンポーネントが重要な役割を果たします。このチップは、コントラスト法と洗練されたアルゴリズムを使用して、最適な焦点を瞬時に評価し、高品質の写真を撮影できます。もちろん、取得したデータに基づいてレンズを目的の位置に機械的に移動する必要がありますが、携帯電話のすべてのカメラは同じように機能します。 「モーター」によって制御されていますが、その動きは回転ではなく直線的です。

一歩進んでいるのが、iPhone 12 Pro (Max) および iPhone 13 Pro (Max) モデルです。ご想像のとおり、これらのモデルにはいわゆる LiDAR スキャナーが搭載されており、撮影した被写体からの距離を瞬時に判断し、その知識を活用できます。実際、この技術は前述のレーザー焦点に近いものです。 LiDAR はレーザー ビームを使用して周囲の 3D モデルを作成できるため、主に部屋や自動運転車のスキャン、および写真 (主にポートレート) の撮影に使用されます。

かもしれない 興味がありますか

アダム・コス

アダム・コス

Apple と一緒に世界中を飛び回る

Apple と一緒に世界中を飛び回る