先週末、私たちは、児童虐待を描いた画像を検出するための新しいシステムという、かなり興味深い新製品についてお知らせしました。具体的には、Apple は iCloud に保存されているすべての写真をスキャンし、検出された場合は関係当局に報告します。このシステムはデバイス内で「安全に」動作しているが、この巨人は依然としてプライバシーを侵害しているとして批判されており、このことは人気内部告発者のエドワード・スノーデン氏も公表した。

かもしれない 興味がありますか

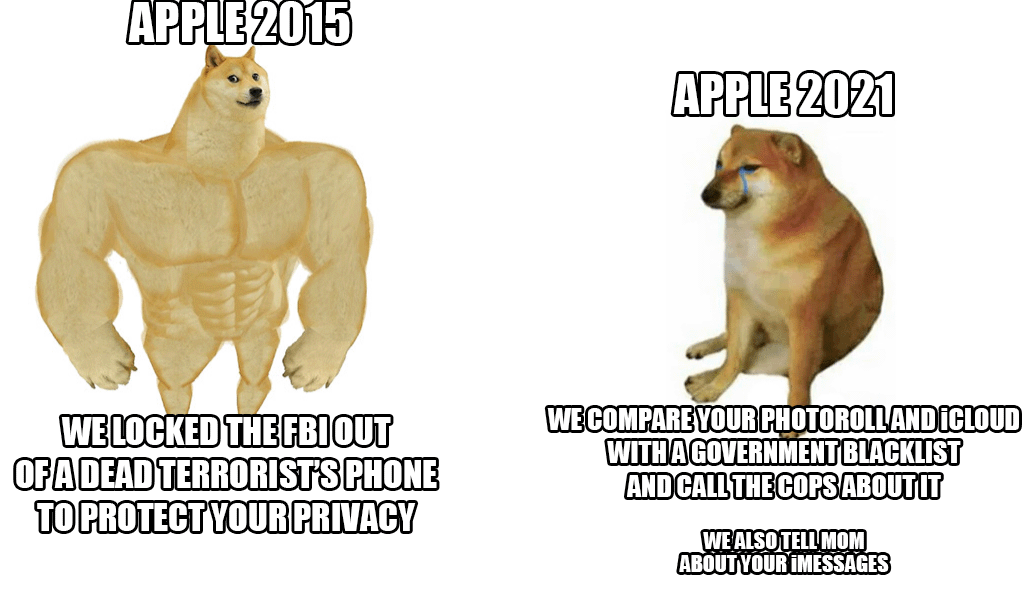

問題は、Apple がこれまでユーザーのプライバシーに依存しており、いかなる状況下でもそれを保護したいと考えていることです。しかし、このニュースは彼らの当初の態度を直接混乱させます。リンゴ生産者は文字通り既成事実に直面し、2つの選択肢のどちらかを選択しなければなりません。特別なシステムで iCloud に保存されているすべての写真をスキャンするか、iCloud 写真の使用を中止するかのどちらかです。そうすれば、全体が非常に簡単に機能します。 iPhone はハッシュのデータベースをダウンロードし、写真と比較します。同時に、ニュースにも介入し、子供たちを保護し、危険な行動について親にタイムリーに知らせることになっている。その場合、誰かがデータベース自体を悪用する可能性があるという事実から懸念が生じます。さらに悪いことに、システムが写真だけでなく、メッセージやすべてのアクティビティもスキャンする可能性があるということです。

もちろん、Apple は批判に対してできるだけ早く対応する必要がありました。このため、たとえば同社は FAQ 文書を公開し、システムは写真のみをスキャンし、ビデオはスキャンしないことを確認しました。彼らはまた、他のテクノロジー大手が使用しているものよりもプライバシーに優しいバージョンであると説明しています。同時に、アップル社は、全体が実際にどのように機能するかをさらに正確に説明しました。データベースと iCloud 上の画像を比較したときに一致する場合、その事実に対して暗号で保護されたバウチャーが作成されます。

すでに上で述べたように、このシステムは比較的簡単にバイパスできることも Apple によって直接確認されています。その場合は、iCloud 上の写真を無効にするだけで、検証プロセスを簡単に回避できます。しかし、疑問が生じます。その価値はありますか?いずれにせよ、少なくとも現時点では、このシステムがアメリカ合衆国でのみ導入されているという明るいニュースが残っている。この制度をどう見ていますか?欧州連合加盟国での導入に賛成ですか、それともプライバシーへの侵害が多すぎますか?

うーん、複雑ですね。もちろん、プライバシー保護は何よりも優先されます。それは私がこのプラットフォームを使用する理由の 1 つでもあります。しかし、何事にも限界があります。要するに、あらゆる自由は、他人の自由を侵害した時点で終わります。子どもに危害を加えたり虐待したりしようとする者に対しては、行動を起こさなければならないことは明らかです。それは議論の余地がありません。

すでに上で述べたように、このシステムは比較的簡単にバイパスできることも Apple によって直接確認されています。その場合は、iCloud 上の写真を無効にするだけで、検証プロセスを簡単に回避できます。

同時に、共有アルバムをオフにすることも意味します。親愛なるワトソン君、なんと単純なことでしょう :)

指定された機関の許可なしに自動的に写真を漁ることは原則として間違っており、これは最初のステップにすぎないと私は確信しています。最初は正当化されても、もう止められなくなることはたくさんある 児童ポルノ→白身の肉の取引→動物虐待→運転に注意しない→反対運動への参加パーティー...

問題は、このプロセスを可能にするものです。なぜ携帯電話や OS のメーカーがユーザーとして何を入れるべきかを私たちに指示しなければならないのでしょうか?もちろん、特に適切な子供たちにとっては、それを聞くのが非常に楽しいため、Apple はこの問題に対処する最先端のデバイスのスポンサーになっています。子どもたちは国家に興味がないのに、なぜ非営利団体がそれを解決するのでしょうか?何も悪いことをしていないのであれば特に気にしませんが、iPhone/iPad ユーザー全員が犯罪者になる可能性があります。これはねじれた論理ですが、最も簡単な解決策の 1 つは、写真を安全にスキャンすることだと思います。そのため、iMessage 経由で私に児童ポルノを送信する人は皆、私が犯罪者で、興味のないことで民間企業の責任を問われることになり、その間は ID がブロックされるためログインしないことにイライラしています。そして、子供の写真を共有してクラウドにバックアップするほど愚かなイライラした人々は、最も愚かな人々がこれに引っかかるので、他の場所に行くでしょう。さらに、誤ってピンディク/ピピンカと一緒に子供の写真を撮った両親もいます。よくやった。

なぜ彼らは、裸の子供の写真を撮った親を捕まえるのでしょうか?それはうまくいきません

はい、書き方を間違えたのでうまくいかないかもしれません。そしてさらに ?